当摄像头对准你时,它不只会告诉别人“这是张三”,还能悄悄补上一句:“他今天看起来很开心,概率 92%。” 想象一下,这样的系统既能识别人脸身份,又能捕捉情绪状态,让机器学会“看脸识人,也看懂心”。在这篇文章里,我们将基于 OpenCV,带你一步步实现这个双识别系统,从人脸检测、关键点提取,到特征计算和分类模型,再到实时可视化展示,完整走一遍流程。轻量、直观,还能落地在考勤、课堂、客服等场景中,让技术和生活贴得更近。

在这篇文章里,我们要实现一个“一举两得”的系统:既能识别人是谁,又能识别他当下的情绪。换句话说,不仅能“看脸识人”,还能“看懂心情”。下面我会带你理清整个系统的设计思路,从输入到输出,一步步串起来。

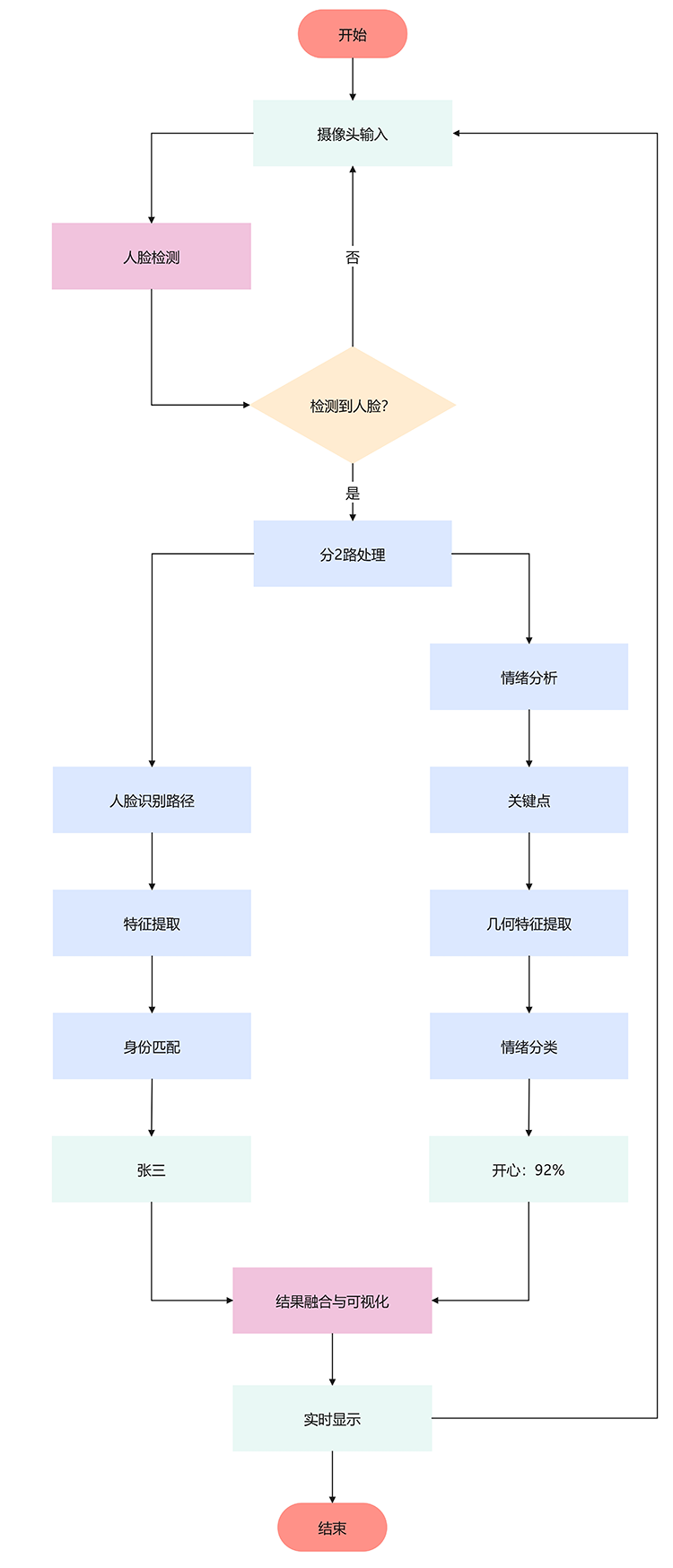

一、系统整体架构

整个系统可以分成两大模块:人脸识别和情绪分析。前者负责确认身份,例如“张三”“李四”;后者则判断当下的情绪,比如“开心”“生气”“惊讶”。最终,两部分的结果会在同一个视频流中融合展示,比如:

图1 人脸与情绪双识别融合展示示例

这样,用户在镜头前时,系统不仅能告诉你“这是谁”,还会实时标注出“他是什么心情”。

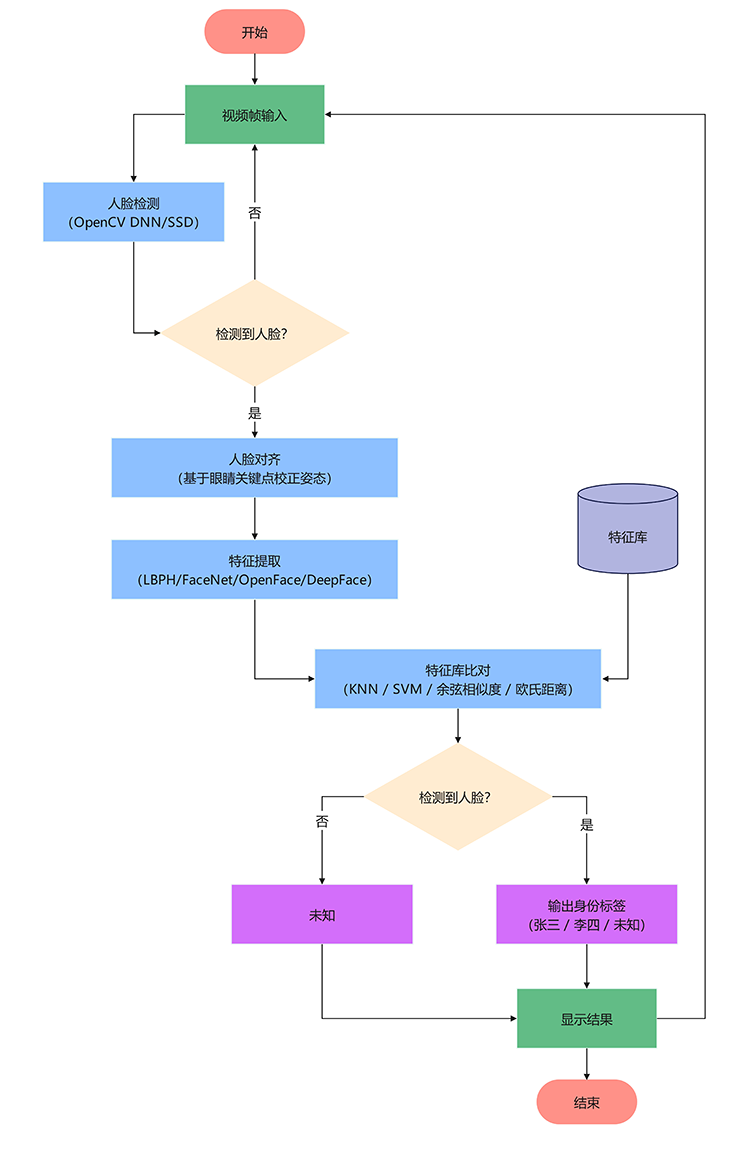

二、人脸识别模块

人脸识别模块的目标是回答“你是谁?”。在实际运行中,系统会先通过 OpenCV 的 DNN 模型(基于 SSD/Caffe)对输入的视频帧进行人脸检测,找到人脸的大致区域。随后,利用眼睛位置等关键点对人脸进行对齐操作,确保输入的人脸姿态统一,从而减少角度、光照等差异带来的影响。

完成对齐后,系统进入特征提取阶段。常见做法有两类:一类是传统方法,比如 LBPH(Local Binary Patterns Histograms),它依赖局部纹理特征,速度快、实现简单,适合小规模应用;另一类是深度学习方法,如 FaceNet、OpenFace 或 DeepFace,这类模型可以将人脸映射到高维特征空间,更好地区分不同个体,适合大规模应用。最终,提取到的特征会存入数据库,并通过 **KNN、SVM 或相似度度量(余弦/欧氏距离)**进行比对,输出身份标签,例如“张三”。

图2 人脸识别模块流程图

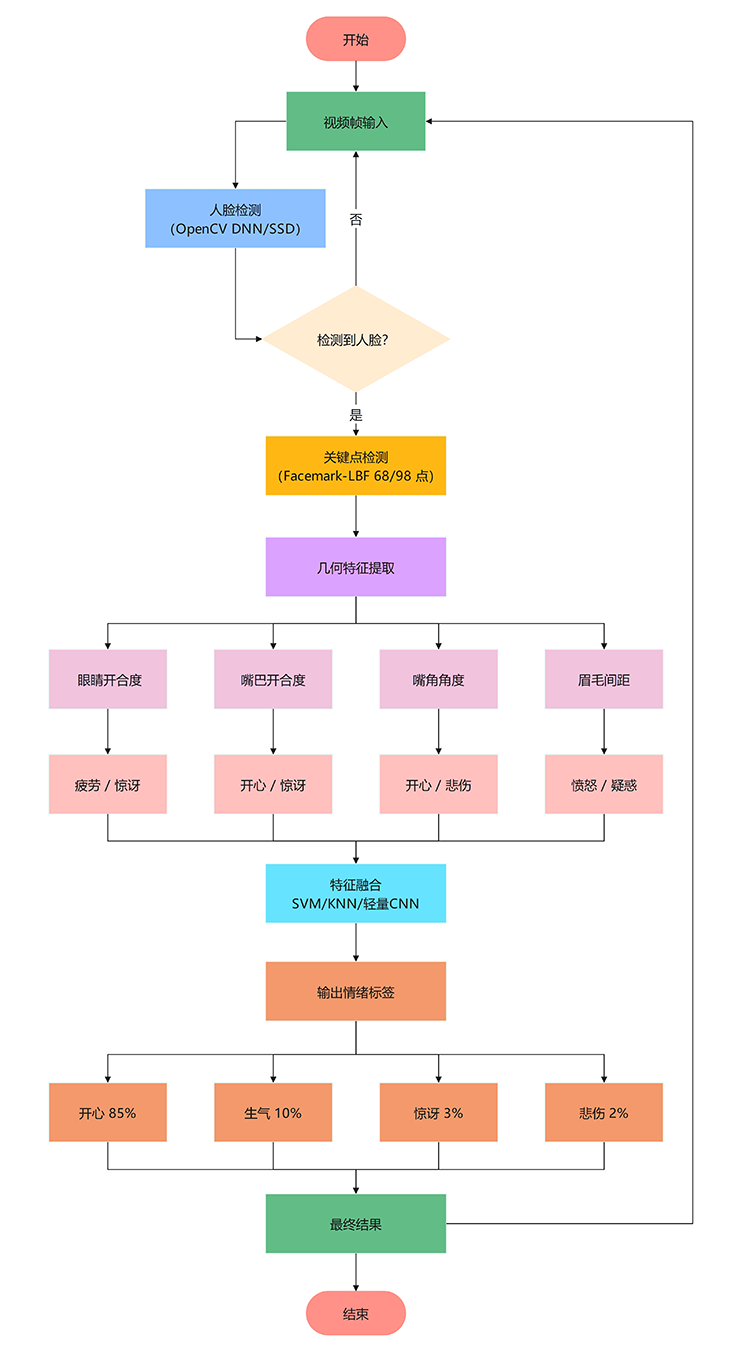

三、情绪分析模块

情绪分析模块则回答“你现在什么情绪?”。在检测到人脸后,系统会使用 OpenCV 的 Facemark-LBF 提取 68 或 98 个关键点,这些关键点覆盖眼睛、眉毛、嘴角等面部特征区域。基于这些关键点,可以计算出一系列几何特征,例如:眼睛开合度(EAR,用于判断疲劳或惊讶)、嘴巴开合度(MAR,用于检测开心或惊讶)、嘴角角度(区分开心和悲伤)、眉毛间距(反映愤怒或疑惑)。

这些特征会作为输入送入分类模型。对于数据量较小的场景,可以使用 SVM 或 KNN 进行快速分类;而在大规模数据或需要更高精度时,轻量化的 CNN 更合适,能显著提升泛化能力。最终,系统会输出一个情绪标签及其概率,比如“开心 (92%)”,让人不仅能看见谁在镜头前,还能知道他的表情含义。

图3 情绪分析模块流程图

四、融合与可视化

当身份识别和情绪分析都完成后,系统会将两部分结果融合,并实时展示在视频流中。每个人脸的矩形框上方会显示类似 “张三 · 开心 (92%)” 的标签,让用户一眼就能看懂系统的判断。同时,关键点也会被绘制在画面中,用不同颜色标记眼睛、嘴巴和眉毛等区域,增加可视化的直观性。

整个展示过程是实时的,随着摄像头画面的更新不断刷新结果。这样的设计不仅提高了交互性,还能让用户清晰直观地感受到系统的识别能力。

图4 系统总体流程图

五、系统特色

这个系统最大的特色在于 双重识别,也就是同时输出身份和情绪,实现“一次检测,两种结果”。它依托 OpenCV 实现,整体结构轻量、易于上手,即便在普通电脑上也能保证实时运行。

更重要的是,这套系统具备很强的扩展性。它不仅能用于基础的身份验证,还能嵌入到考勤系统、课堂专注度检测、智能客服甚至驾驶监测等应用场景中,真正做到既有学术价值,又能在实际中落地。

五、总结

总体来看,这套系统的设计思路非常清晰:先做人脸检测 → 分两路(身份识别 + 情绪分析) → 融合输出 → 实时展示。这样的流程既保证了模块化的清晰结构,又能在实际应用中保持高效和准确。

最终,你的电脑摄像头就不再只是“看见你”,而是能够“看懂你”。这也意味着从人脸识别到情绪感知的结合,正在让人机交互变得更加自然和智能。

评论(0)