摘要:随着人口老龄化加剧,独居老人的居家安全问题日益突出。其中,摔倒是导致独居老人意外伤亡的重要原因之一;由于其在摔倒后往往难以及时获得救助,构建实时、准确的摔倒识别系统具有重要现实意义。

项目简介

一个基于YOLO11人体检测、AlphaPose骨骼关键点提取和ST-GCN时序动作分类的实时独居老人摔倒识别系统,支持摄像头监控、自动报警与日志记录。

系统概述

随着人口老龄化加剧,独居老人的居家安全问题日益突出,摔倒是导致独居老人意外伤亡的主要原因之一。由于独居老人摔倒后往往无法及时获得救助,实时准确的摔倒识别系统对于保障其生命安全具有重要现实意义。

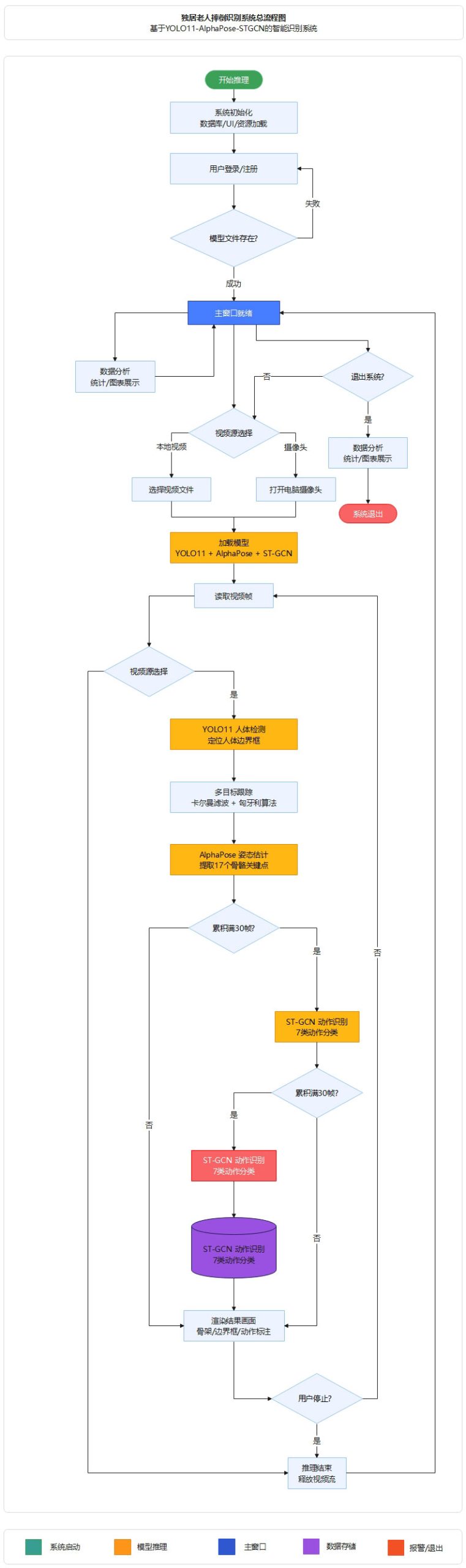

本文设计并实现了一套基于YOLO11-AlphaPose-STGCN的独居老人摔倒识别系统,构建了”人体检测—姿态估计—动作识别”三阶段级联处理框架。在人体检测阶段,采用YOLO11轻量化目标检测模型实现视频帧中的人体定位,并结合卡尔曼滤波与匈牙利算法进行多目标跟踪以维持身份一致性;在姿态估计阶段,利用AlphaPose(FastPose-ResNet50)提取每个目标的17个二维骨骼关键点坐标;在动作识别阶段,将连续30帧的骨骼序列输入双流时空图卷积网络(Two-StreamST-GCN),同时建模关节位置与关节运动速度特征,实现对站立、行走、坐下、躺下、起立、坐下及摔倒共7类动作的分类识别。系统基于PyQt5设计了图形化操作界面,支持视频文件与实时摄像头输入,并实现了摔倒报警与日志记录功能。

在自建的室内场景数据集上进行实验,结果表明该系统在保持实时处理速度的同时,对摔倒动作具有较高的识别准确率和召回率,能够有效区分摔倒与躺下等相似动作,可为独居老人居家安全监护提供一套完整、实用的技术解决方案。

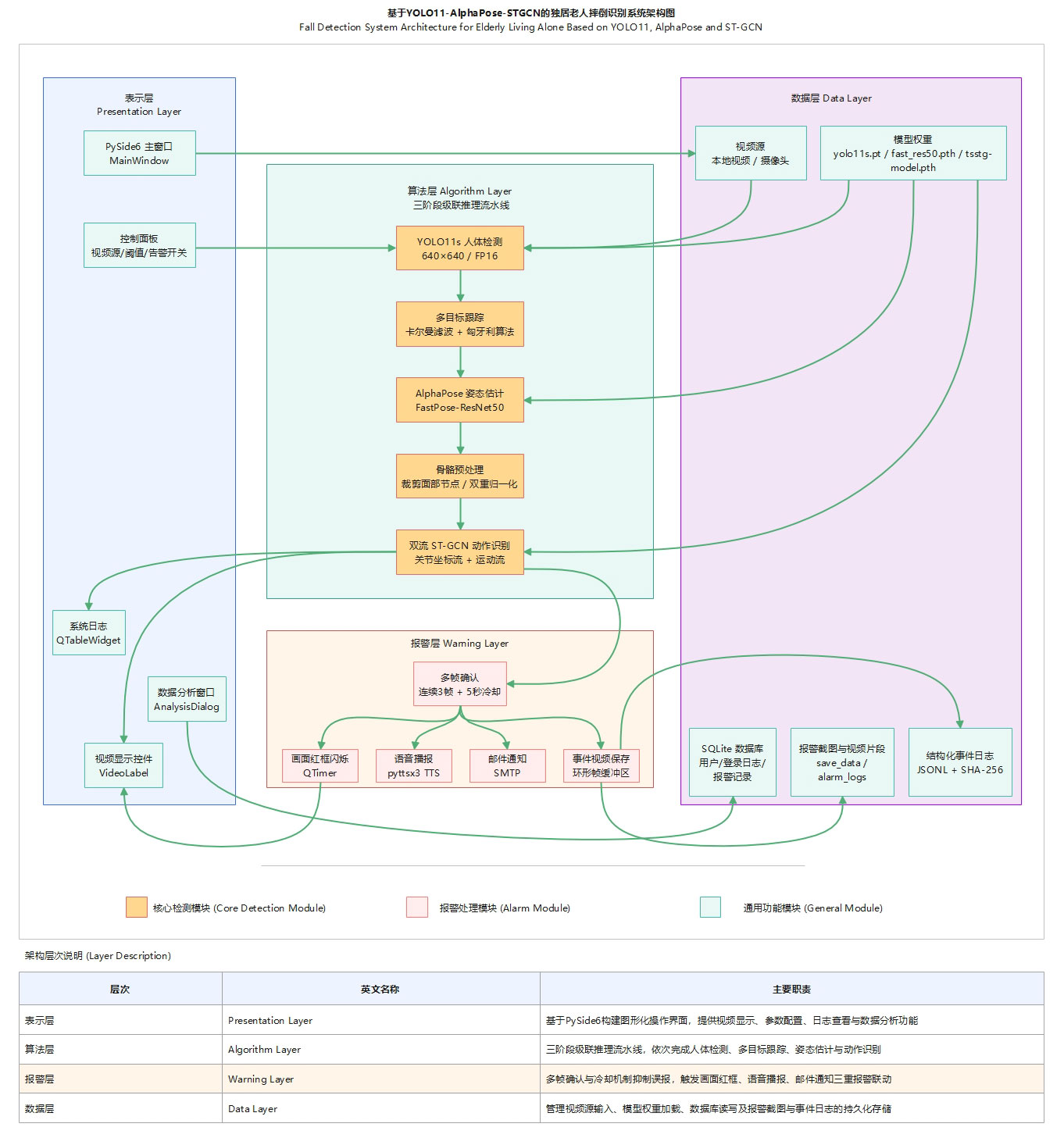

系统架构

系统采用表示层(PySide6界面)、算法层(YOLO11s检测→卡尔曼跟踪→AlphaPose姿态估计→双流ST-GCN动作识别)、报警层(多帧确认+语音/邮件/红框三重联动)、数据层(SQLite+JSONL日志)四层架构。

图1 基于YOLO11-AlphaPose-STGCN的独居老人摔倒识别系统架构图

核心亮点

双流ST-GCN同时建模关节位置与运动速度特征,结合多帧确认与冷却机制,有效区分摔倒与躺下等相似动作,降低误报率。

算法特点

本系统在算法层面具有以下特点:

空间配置图分区策略 — 骨骼图邻接矩阵采用空间配置分区(Spatial Configuration Partitioning)策略,以颈部中点为重心节点,将邻居节点按其与重心的拓扑距离划分为向心、离心和等距三个子集,分别进行图 卷积运算,增强了模型对躯干与四肢空间层次关系的表征能力。

自适应边重要性学习机制 — 每层ST-GCN引入独立的可学习参数矩阵作为边重要性权重,与邻接矩阵逐元素相乘,使网络能够自 适应地学习不同骨骼连接对动作分类任务的贡献程度。

精简骨架拓扑结构 — 基于COCO关键点格式,裁剪眼部和耳部共4个面部节点,保留14个躯干及四肢节点,并通过左右肩坐标均 值构造虚拟颈部节点,在降低面部噪声干扰的同时保留了与摔倒动作密切相关的身体结构信息。

双重坐标归一化处理 — 对输入骨骼序列依次进行图像尺寸归一化(映射至[0,1]区间)和姿态尺度归一化(按每帧极值缩放至[ -1,1]区间),有效消除了目标在画面中位置偏移与尺度变化的影响。

渐进式特征升维与残差学习 — 网络由10层图卷积模块堆叠构成,通道维度沿64→128→256逐步递增,配合残差连接保持梯度流通 ,并通过时间维度步长下采样逐层提取更高层次的时空抽象特征。

性能特点

YOLO11n半精度推理搭配15节点精简骨架图与30帧滑动窗口,三模型全程GPU推理,配合3帧确认+5秒冷却机制抑制误报,实现实时摔倒识别。

轻量化检测前端 — 采用YOLO11n作为人体检测模型,输入分辨率640×640,支持FP16半精度推理加速,在保证检测精度的前提下 降低计算开销,为后续姿态估计和动作识别预留充足的时间预算。

高效骨架表征 — 骨骼图仅保留14个躯干四肢节点加1个虚拟颈部节点,相比完整COCO 17点减少约12%的图节点数,直接降低了图卷积的计算复杂度。

双流并行特征提取 — 关节坐标流与运动流经两个独立的10层ST-GCN网络并行前向传播,最终拼接为512维特征向量(256×2), 通过单层全连接完成7类分类,结构简洁高效。

30帧滑动窗口推理 — 以30帧为一个时间窗口进行动作识别,在视频帧率25-30fps的典型场景下约对应1秒的动作片段,兼顾了 识别时效性与时序信息的充分利用。

多帧确认抑制误报 — 系统层面引入连续3帧确认机制与5秒冷却间隔,避免单帧误检触发报警,有效降低了摔倒与躺下等相似动作的误报率。

端到端GPU加速 — 检测、姿态估计、动作识别三个模型均部署在同一GPU设备上,减少CPU-GPU数据搬运开销,支持实时视频流处理。

系统特色

三阶段级联算法与PySide6界面深度集成,支持视频/摄像头双模式输入,具备语音、邮件、画面红框三重报警联动及数据库日志记录与数据分析功能。

技术价值

本系统具有较高的技术应用价值。在算法层面,采用基于骨骼关键点序列的动作识别方案,相比直接对原始视频图像进行分类,不仅大幅降低了输入数据维度和计算量,还天然规避了居家场景下的隐私敏感问题,仅需处理抽象的关节坐标即可完成摔倒判定。在工程层面,系统将YOLO11、AlphaPose、ST-GCN三个异构深度学习模型整合为统一的实时推理流水线,全程GPU加速,并通过卡尔曼滤波与匈牙利算法实现跨帧身份跟踪,保证了多人场景下动作识别的连续性与准确性。在应用层面,系统集成了语音播报、邮件通知、画面红框闪烁三重报警机制,配合多帧确认与冷却策略有效抑制误报,同时提供数据库日志记录与可视化数据分析功能,形成了从实时检测到事后追溯的完整闭环。整体方案部署成本低、扩展性强,可为独居老人居家安全监护、养老机构智能管理等智慧养老场景提供实用的技术支撑。

核心技术

本系统的核心技术围绕”检测—跟踪—姿态估计—动作识别”四个环节展开。在人体检测环节,采用YOLO11s轻量化模型以640×640输入分辨率进行单类别(行人)检测,并开启FP16半精度推理以降低计算延迟。在多目标跟踪环节,基于卡尔曼滤波预测目标运动轨迹,结合匈牙利算法进行检测框与轨迹的最优匹配,维持每个行人在连续帧间的身份一致性,为后续时序动作分析提供稳定的个体骨骼序列。在姿态估计环节,利用AlphaPose的FastPose-ResNet50骨干网络提取每个目标的17个COCO格式二维关键点坐标及置信度分数,经裁剪眼耳4个面部节点并补充虚拟颈部节点后,构建15节点精简骨架图。在动作识别环节,将连续30帧的骨骼序列输入双流时空图卷积网络,关节坐标流与帧间运动流分别经10层ST-GCN独立提取特征,每层采用空间配置分区策略构建邻接矩阵并引入可学习边重要性权重,两路256维特征拼接后经全连接层输出7类动作的概率分布,最终通过Sigmoid激活完成多标签分类。整个推理流水线在同一GPU设备上端到端运行,四个环节紧密衔接,实现了从原始视频帧到摔倒识别结果的实时处理。

算法详解

YOLO11目标检测算法

本系统采用YOLO11n作为人体检测的前端模型。YOLO(You Only Look Once)是一种单阶段目标检测算法,将目标定位与分类统一 为一次前向传播完成,具有速度快、精度高的特点。系统中将YOLO11n的检测类别限定为单类别(person,class=0),输入分辨率 设置为640×640,置信度阈值为0.25,IoU阈值为0.45,在GPU设备上开启FP16半精度推理以降低计算延迟。每一帧图像经YOLO11n处 理后,输出所有检测到的人体边界框坐标(xyxy格式)、置信度分数及类别标签,为后续的姿态估计提供精确的人体裁剪区域。

卡尔曼滤波与匈牙利算法(多目标跟踪)

为保证同一行人在连续帧间的身份一致性,系统采用卡尔曼滤波与匈牙利算法相结合的多目标跟踪方案。卡尔曼滤波器维护一个8维状态空间(中心坐标x、y,宽高比a,高度h及其对应速度vx、vy、va、vh),基于匀速运动模型对每个跟踪目标的下一帧位置进行预测,并在获得新的检测观测后通过测量更新步骤修正状态估计,其中过程噪声和观测噪声的标准差均与目标高度成正比,实现了自适应的不确定性建模。在数据关联阶段,系统采用级联匹配策略:首先对已确认轨迹按丢失时长优先级进行IoU代价的匈牙利匹配,未匹配的轨迹与未确认轨迹再进行二次匹配,最大IoU距离阈值设为0.7。新检测目标需连续匹配成功3次方可确认为有效轨迹,丢失超过30帧的轨迹将被删除。每个轨迹维护一个容量为30帧的骨骼关键点双端队列,为动作识别提供时序输入。

AlphaPose姿态估计算法

姿态估计环节采用AlphaPose框架中的FastPose模型,骨干网络为ResNet50,输入尺寸为224×160。该模型属于自顶向下(Top-Down)的姿态估计方案:首先根据YOLO11输出的人体边界框对原图进行仿射变换裁剪,将每个人体区域缩放至统一尺寸后送入网络,输出各关键点的热力图(Heatmap)。系统在热力图层面直接裁剪掉左右眼和左右耳共4个面部通道(保留鼻子),仅保留13个躯干及四肢关键点,随后通过热力图解码获取二维坐标及置信度分数。解码后的关键点经姿态非极大值抑制(PoseNMS)去除冗余检测,最终输出每个人体的关键点坐标数组及对应分数,供后续动作识别模块使用。

双流时空图卷积网络(Two-Stream ST-GCN)

动作识别环节是本系统的核心算法模块,采用双流时空图卷积网络对骨骼序列进行分类。输入预处理阶段,原始关键点坐标先按图 像尺寸归一化至[0,1]区间,再按每帧姿态的极值缩放至[-1,1]区间以消除位置和尺度影响,同时通过左右肩坐标均值构造虚拟颈 部节点,最终形成15节点、3通道(x, y, score)、30帧的骨骼张量。运动流则由相邻帧关节坐标的差值计算得到,为2通道(Δx, Δy)、29帧的时序张量。两路输入分别送入独立的StreamSpatialTemporalGraph网络,每个网络由10层ST-GCN模块堆叠构成,通 道维度沿64→128→256逐步递增。每层ST-GCN模块包含图卷积(GCN)和时间卷积(TCN)两个子模块:图卷积基于空间配置分区(Sp atial Configuration Partitioning)策略构建3分区邻接矩阵,将邻居节点按与重心节点的拓扑距离划分为向心、离心和等距三 组分别卷积,并引入可学习的边重要性权重矩阵自适应调整各骨骼连接的贡献度;时间卷积采用核大小为9的一维卷积沿时间轴提 取局部时序模式,配合BatchNorm、ReLU激活和Dropout正则化。每层均设有残差连接以保持梯度流通。两路网络各自经全局平均池 化输出256维特征向量,拼接为512维后通过全连接层映射至7类动作输出,最终经Sigmoid激活得到各类别的概率分布,实现对站立 、行走、坐着、躺下、起立、坐下及摔倒七种动作的分类识别。

技术优势分析

YOLO11n 在架构设计上对 YOLOv8 与 YOLOv10 进行了系统性优化。通过引入 C3k2 轻量化模块与 2×2 卷积,在保持检测精度的同时显著降低参数量与计算复杂度;结合 C2PSA 并行空间注意力与 SPPF 模块,增强全局建模能力与多尺度特征表达。检测头采用解耦设计,并引入 DFL 与 TAA 优化回归与样本分配策略,有效提升小目标与复杂场景下的检测性能。综合实验结果表明,YOLO11n 在参数效率、推理速度和检测精度之间取得了更优平衡,适用于车辆细粒度识别等实时应用场景。

性能表现

YOLOv11n基线模型以2.6M参数量、6.6 GFLOPs计算量实现高效推理,在车辆品牌与类型识别任务上达到98.7% mAP@0.5和82.3% mAP@0.5:0.95的优异精度,精确率98.2%,召回率97.2%,支持GPU加速和CPU部署,兼顾轻量化、高精度与实时性的完美平衡。

模型性能分析

YOLOv11n基线模型在车辆品牌与类型识别任务上表现出色,经过150轮训练后,在1,406张验证集上达到98.7% mAP@0.5和82.3% mAP@0.5:0.95的识别精度。模型的精确率为98.2%,召回率为97.2%,意味着误识别率和漏检率均控制在3%以内,能够满足实际应用需求。

该模型采用轻量化设计,仅包含2.6M参数和6.6 GFLOPs计算量,模型文件大小约5.5MB,适合在资源受限的边缘设备上部署。在保持高精度的同时,模型具备良好的实时性能,支持CPU和GPU多种硬件平台,为车辆智能识别系统提供了高效可靠的技术支撑。

关键指标(注:真实数据)

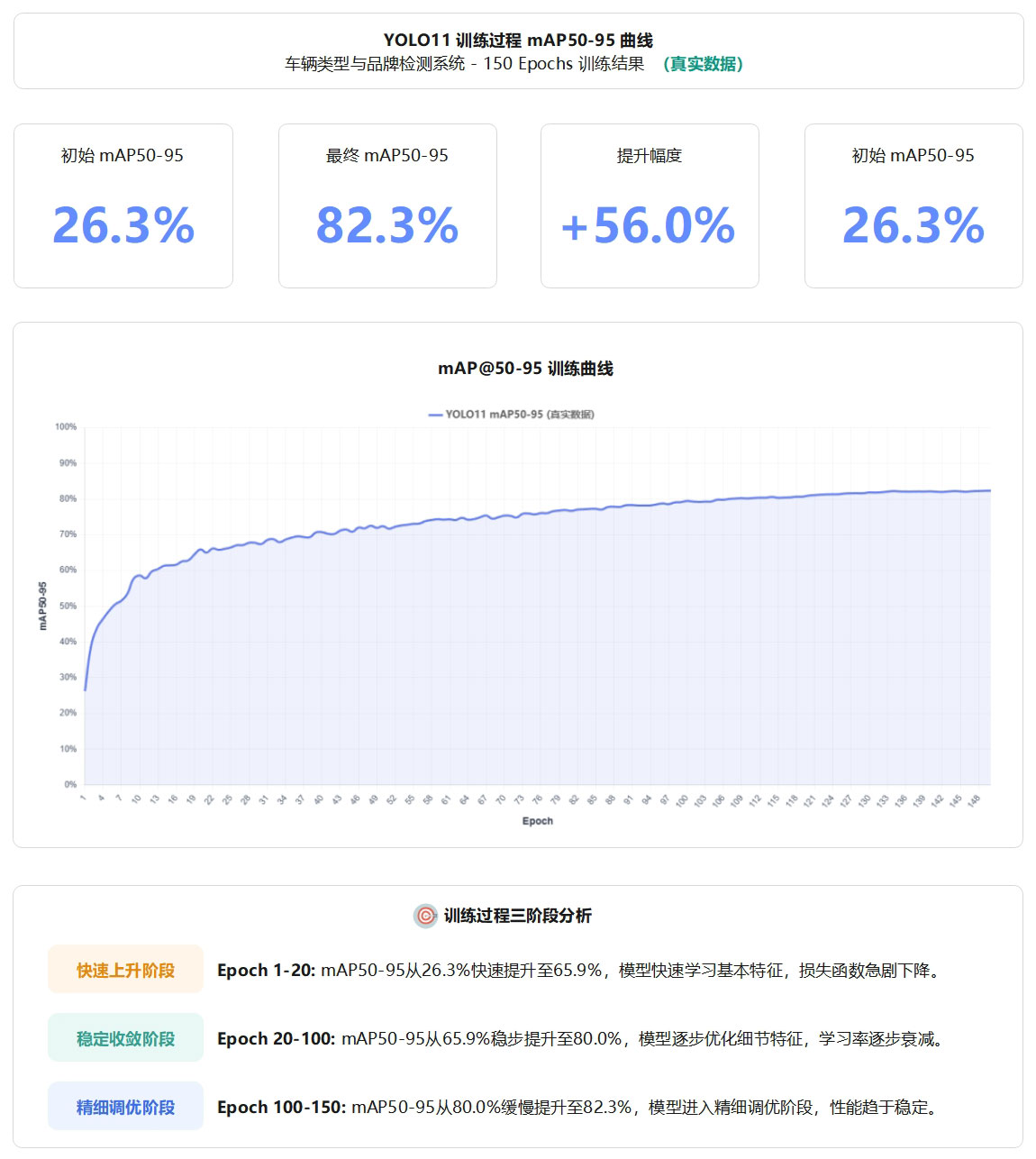

YOLOv11基线模型在150轮训练过程中,mAP@0.5:0.95指标从初始的26.3%稳步提升至最终的82.3%,提升幅度达56.0%。训练过程呈现明显的三阶段特征:快速上升阶段(Epoch 1-20)实现从26.3%到65.9%的跃升,稳定收敛阶段(Epoch 20-100)从65.9%提升至80.0%,精细调优阶段(Epoch 100-150)最终达到82.3%并趋于稳定。

图4 YOLO11训练过程mAP50-95曲线图

该曲线充分展示了模型在车辆品牌与类型识别任务上的学习能力和收敛特性,验证了训练策略的有效性。最终的82.3% mAP@0.5:0.95配合98.7% mAP@0.5,证明模型在严格评估标准下仍保持优异性能。

性能优势总结

本系统以骨骼关键点替代原始图像进行动作分类,天然规避隐私问题;双流ST-GCN分别建模静态姿态与运动速度特征,有效区分摔倒与躺下等易混淆动作;图卷积配合空间分区策略与可学习边权重,实现骨骼拓扑结构的自适应建模;YOLO11s半精度推理与15节点精简骨架图全程GPU部署,保证实时处理能力;多帧确认与多级冷却机制抑制误报,环形帧缓冲区自动保存事件视频片段并生成结构化日志,形成完整的检测-报警-回溯闭环。

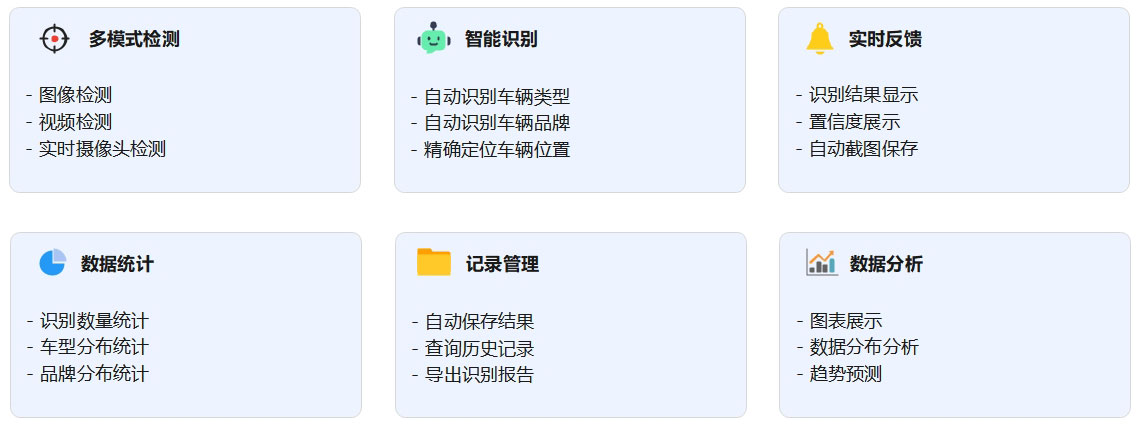

系统功能

支持视频文件与摄像头双模式输入,实时识别7类人体动作并在检测到摔倒时触发画面红框、语音播报、邮件通知三重报警,同时提供用户登录管理、报警截图与事件视频自动保存、结构化日志记录及可视化数据分析功能。

功能概述

本系统实现了从视频输入到摔倒报警的完整功能闭环。在输入端,支持本地视频文件与电脑摄像头两种视频源接入方式。在识别端,系统对视频流进行实时处理,逐帧完成人体检测、骨骼关键点提取与动作分类,可识别站立、行走、坐着、躺下、起立、坐下及摔倒共7类动作。在报警端,当检测到摔倒动作时,系统经多帧确认后触发画面红框闪烁、语音播报及邮件通知三重报警联动,并自动保存报警截图与事件前后各5秒的视频片段。在管理端,系统提供用户登录与注册、检测阈值调节、告警开关配置、系统日志实时查看及历史报警数据的可视化统计分析功能。

系统架构

本系统采用 Python 3.12 开发,基于 Ultralytics YOLOv11 深度学习框架实现目标检测,使用 PySide6 (Qt for Python) 构建现代化图形用户界面,通过 OpenCV 进行图像和视频处理,采用 DetectWorker 多线程异步处理技术保证界面流畅性,并使用 SQLite 数据库实现数据持久化存储和查询,系统架构清晰、模块化设计,便于功能扩展和维护。

图2 基于YOLO11-AlphaPose-STGCN的独居老人摔倒识别系统总流程图

系统优势

本系统基于骨骼关键点进行动作分类,不依赖人体外观特征,天然保护被监护者隐私;双流ST-GCN联合建模姿态形态与运动速度,有效区分摔倒与躺下等易混淆动作;三阶段级联架构全程GPU部署,满足实时处理需求;多帧确认与多级冷却机制逐层抑制误报;事件视频自动保存与SHA-256校验日志形成完整证据链;PySide6图形界面集成检测、报警、管理与数据分析功能,开箱即用,部署成本低,适用于独居老人居家监护与养老机构智能管理等场景。

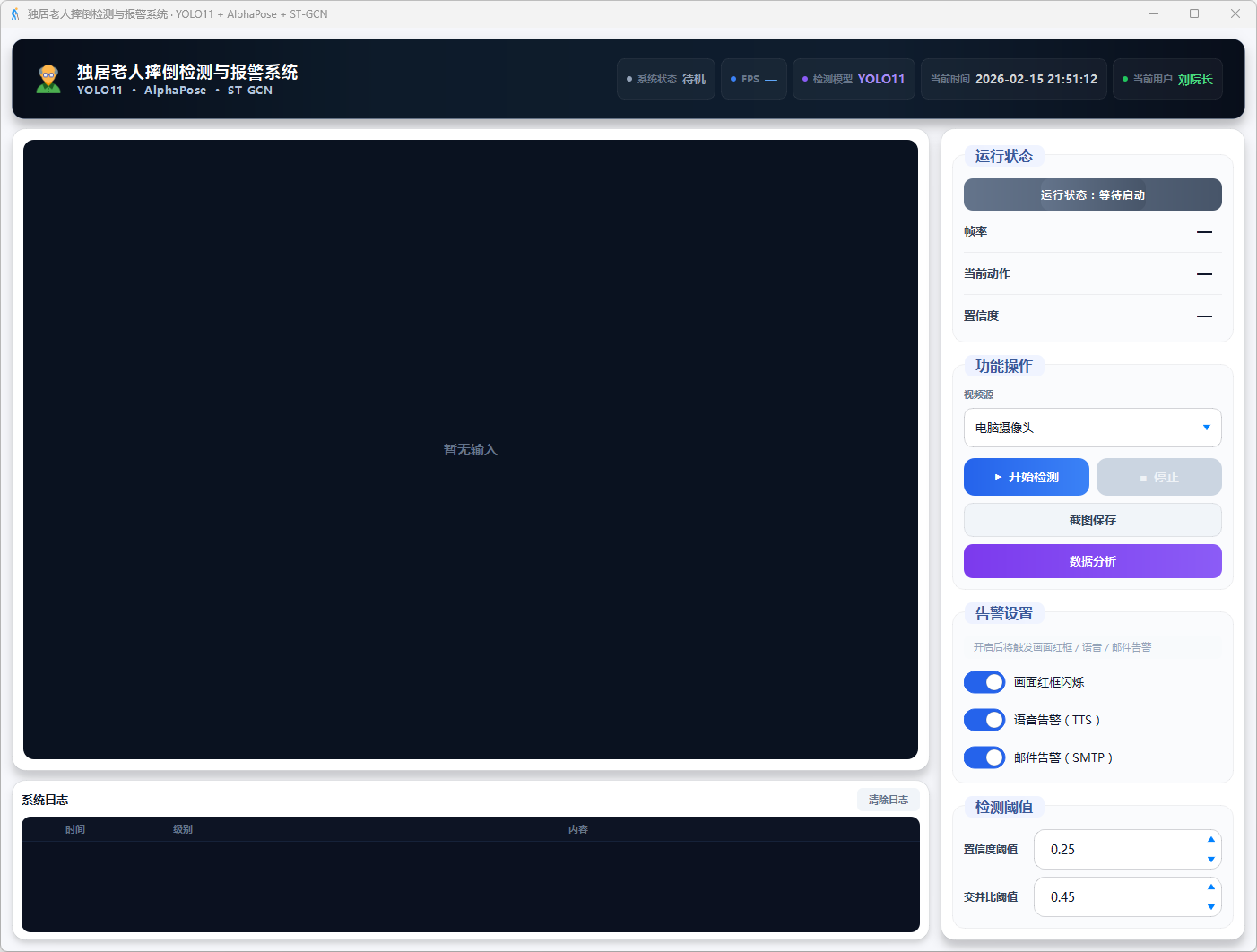

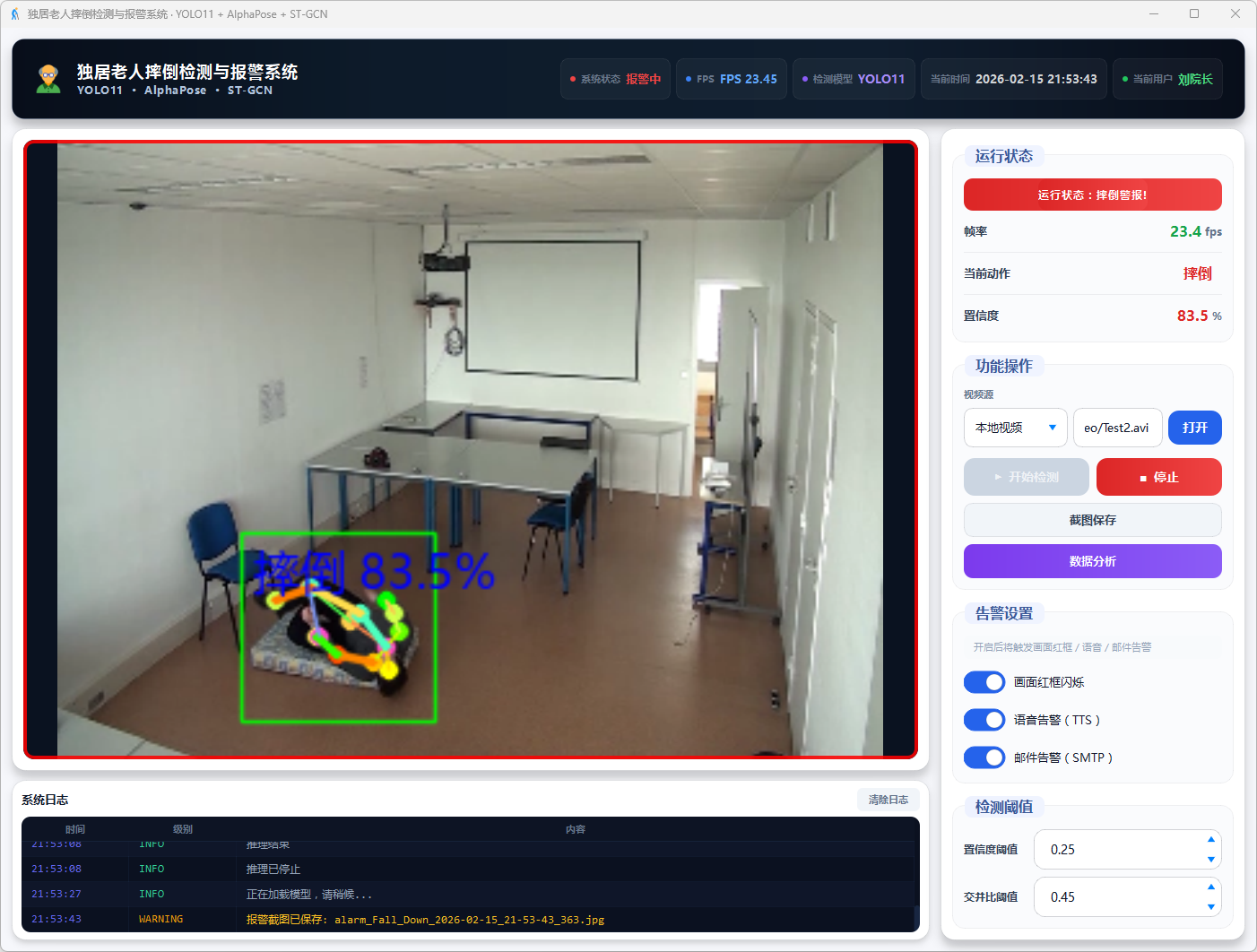

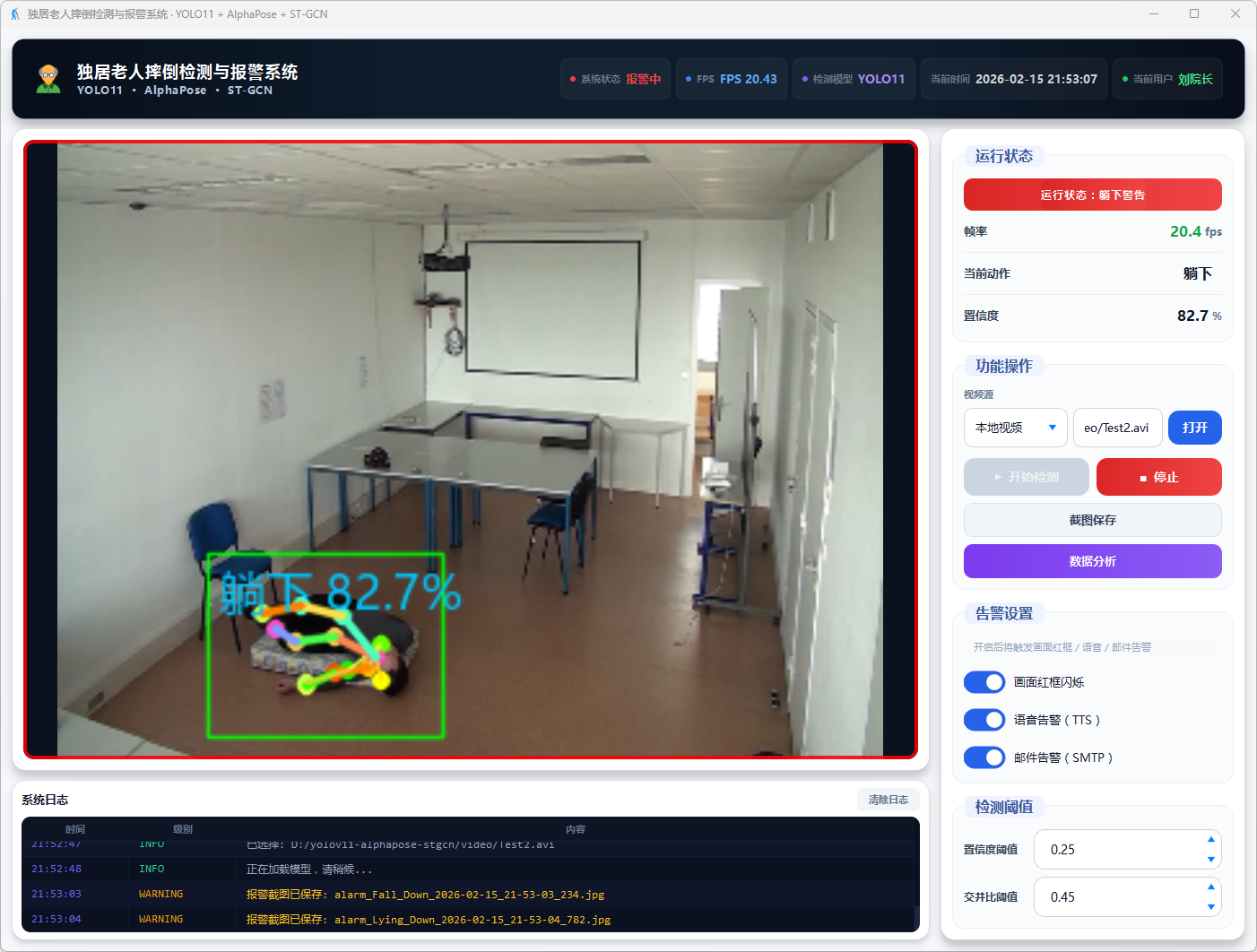

运行展示

系统运行后通过PySide6主界面实时展示视频画面、骨骼姿态叠加、动作分类结果及FPS帧率,摔倒时画面边框红色闪烁并在日志区同步输出报警记录

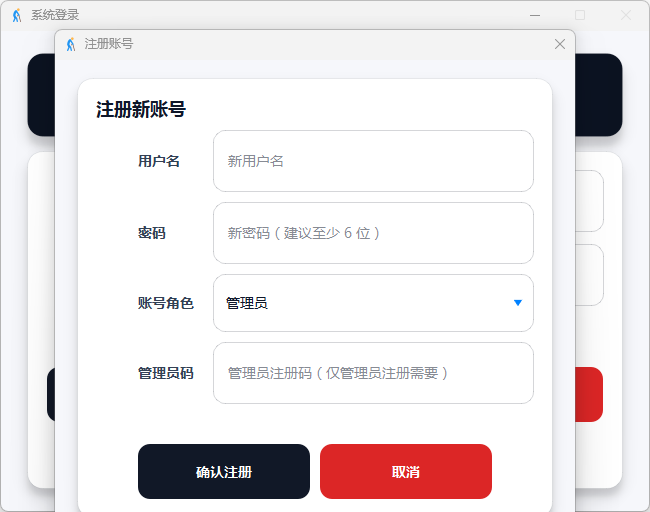

登录和注册

图3 登录主界面

图4 用户注册主界面

图5 管理员注册主界面

检测效果展示

系统运行模块:

图6 系统运行界面

图7 视频检测:摔倒警告

图8 视频检测:躺下警告

图8 实时检测:摔倒警告

图8 实时检测:躺下警告

数据分析模块:

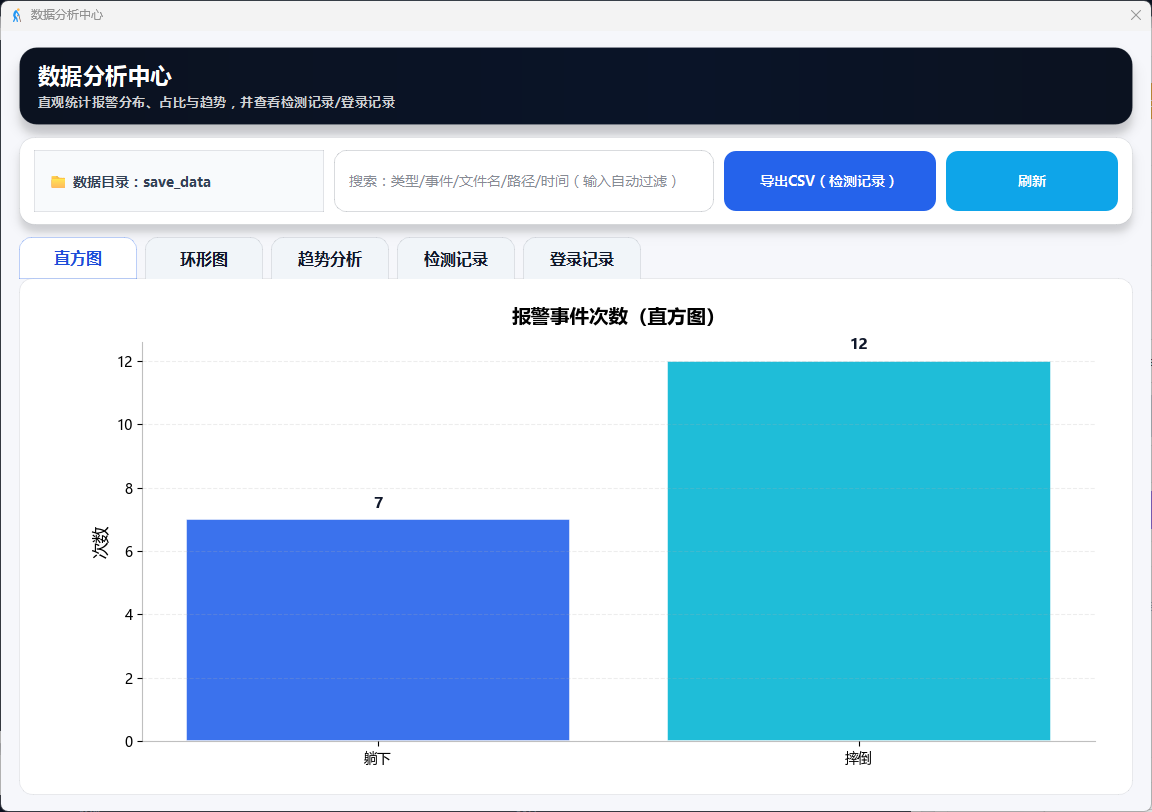

图9 数据分析:直方图

图10数据分析:环形图

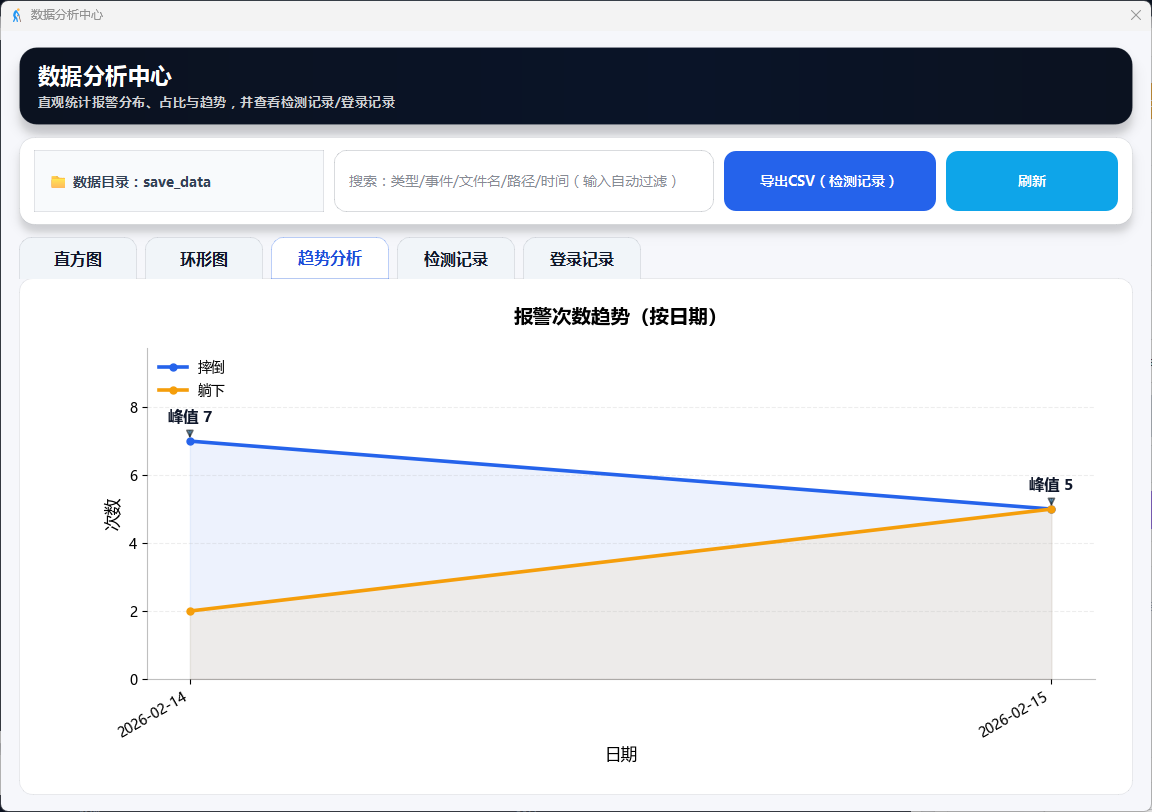

图11 数据分析:趋势分析

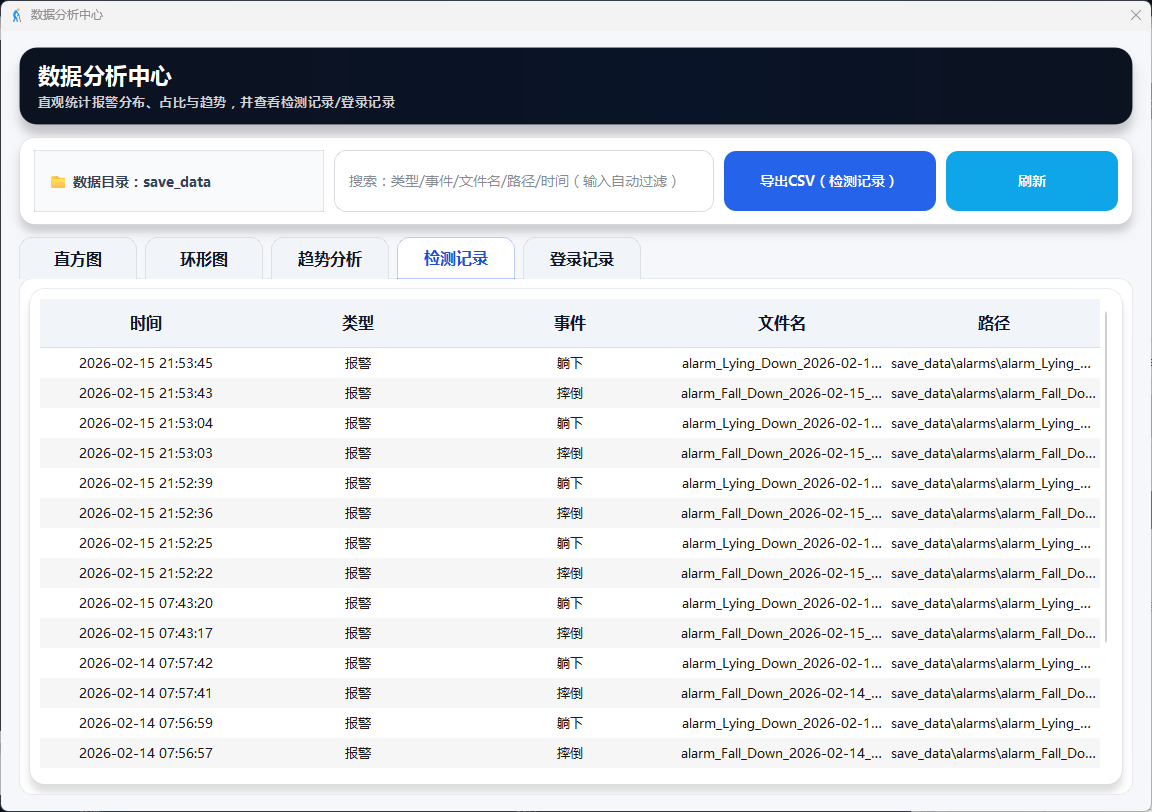

图12 数据分析:检测记录

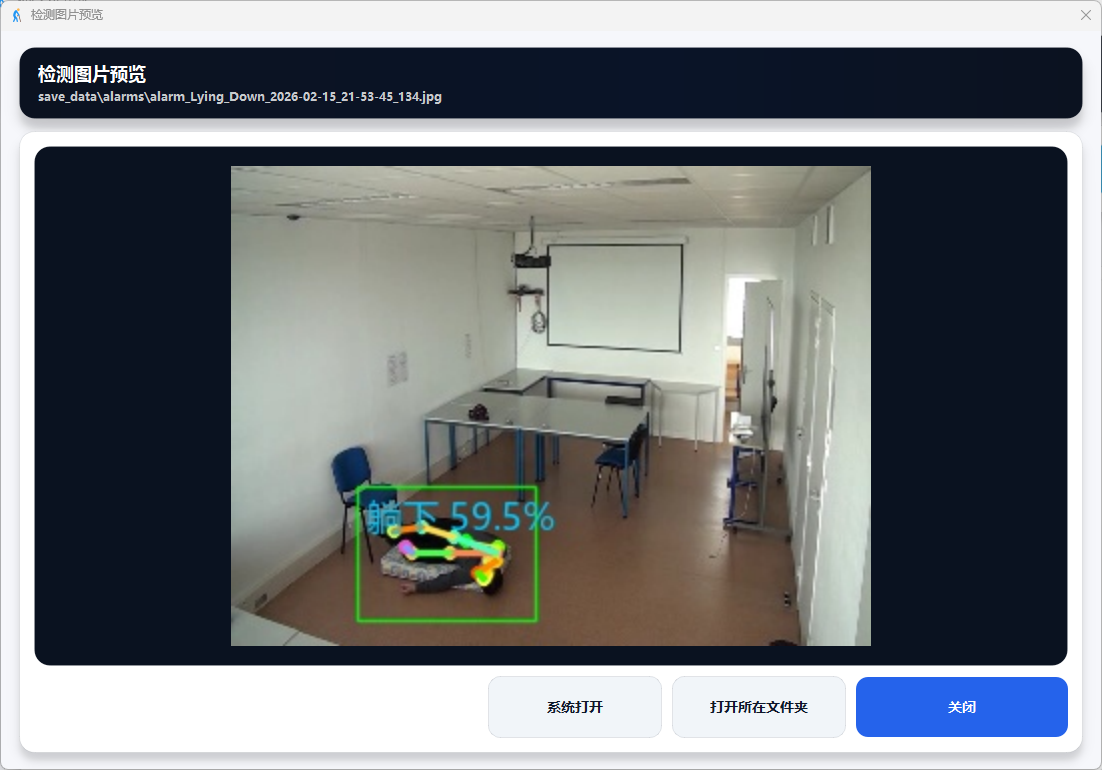

图13 数据分析:检测图片预览

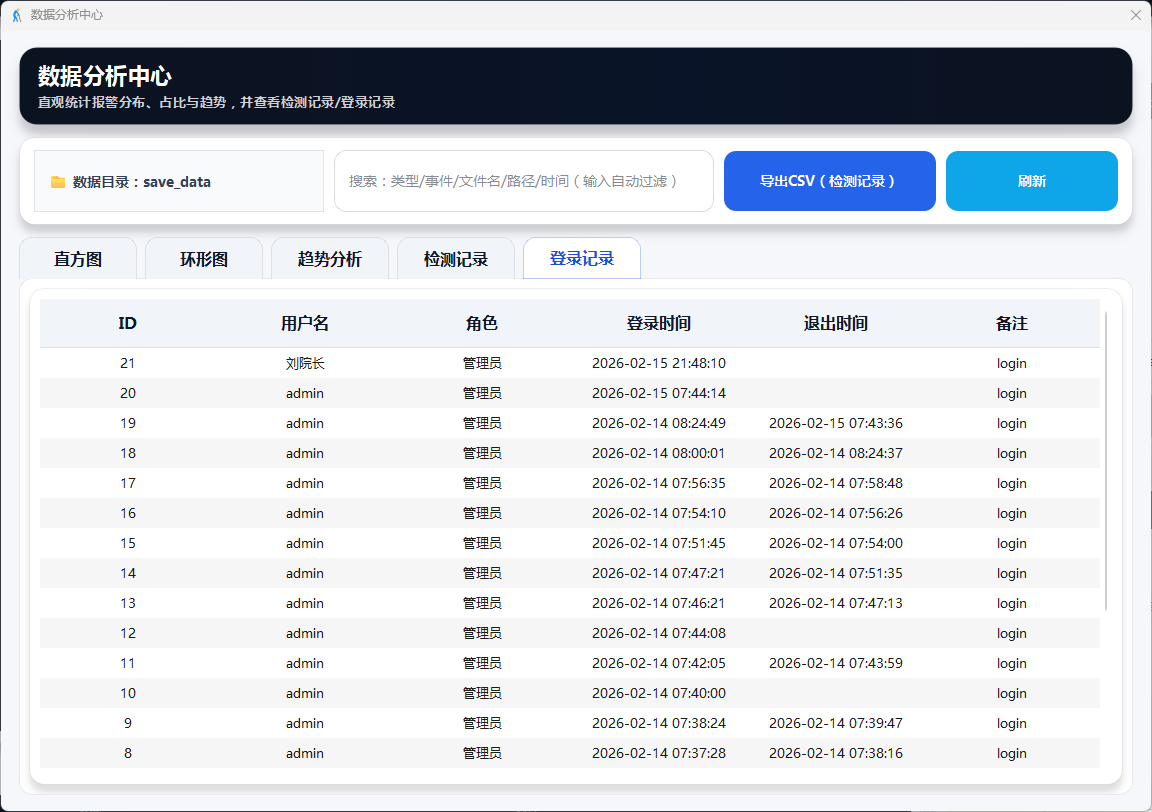

图14 数据分析:登录记录

图15 数据分析:导出检测记录

数据集与训练

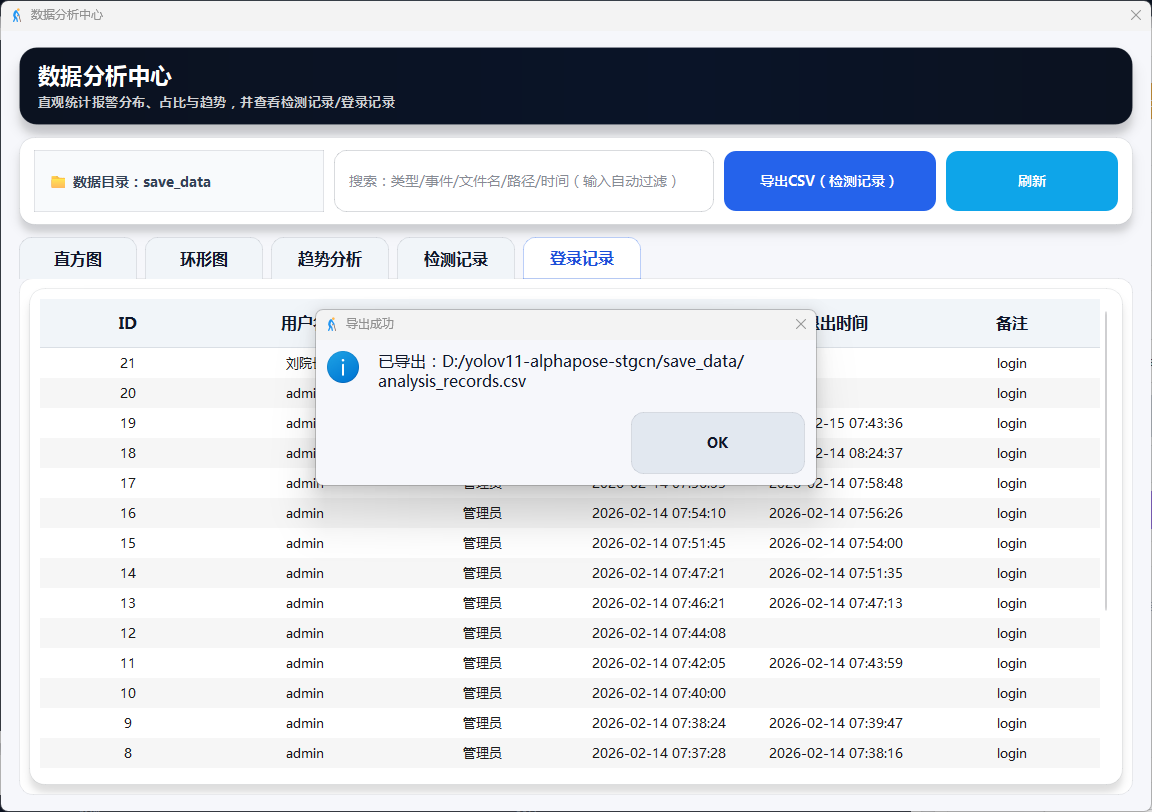

本章介绍了车辆品牌与类型识别数据集的构建过程、模型训练流程与配置,以及YOLOv11基线模型在验证集上达到98.7%的mAP@0.5和82.3%的mAP@0.5:0.95的优异性能。数据集包含7,029张高质量标注图像(训练集4,920张、验证集1,406张、测试集703张),涵盖28个识别类别(22个车辆品牌和6个车型类别),经过150轮充分训练,模型精确率达98.2%、召回率达97.2%,展现出卓越的识别能力和实用价值。

数据集构建

本研究使用的是车辆品牌与类型识别数据集,该数据集专门针对道路、停车场等场景中的车辆进行品牌和类型标注。数据集包含多种场景下的图像,涵盖室内外不同光照条件、不同拍摄角度和距离,包含22个主流车辆品牌(涵盖中国、德国、日本、美国等国家品牌)和6个车型类别(轿车、轿跑、皮卡、SUV、MPV、卡车),具有较强的场景多样性和实用价值。数据集共包含7,029张高质量标注图像,按照约7:2:1的比例划分为训练集(4,920张)、验证集(1,406张)和测试集(703张),为模型训练和评估提供了充足的数据支撑。

图51 数据集划分及类别信息统计示意图

数据集特点:

本研究使用的是车辆品牌与类型识别数据集,该数据集专门针对道路、停车场等场景中的车辆进行品牌和类型标注。数据集包含多种场景下的图像,涵盖室内外不同光照条件、不同拍摄角度和距离,包含22个主流车辆品牌(涵盖中国、德国、日本、美国等国家品牌)和6个车型类别(轿车、轿跑、皮卡、SUV、MPV、卡车),具有较强的场景多样性和实用价值。数据集共包含7,029张高质量标注图像,按照约7:2:1的比例划分为训练集(4,920张)、验证集(1,406张)和测试集(703张),为模型训练和评估提供了充足的数据支撑。

数据集划分:

数据集按照约 70:20:10 的比例划分为训练集、验证集和测试集:

表1 数据集划分及用途说明

训练集用于模型的参数学习和特征提取能力训练。验证集用于训练过程中的性能监控和超参数调优,帮助选择最优模型。测试集用于最终的性能评估,确保模型在未见过的数据上具有良好的泛化能力。

图52 数据集在训练、验证和测试集上的分布

数据预处理:

所有输入图像统一调整为 640×640 分辨率,采用letterbox填充方式保持原始长宽比,避免图像拉伸变形导致车辆特征失真,确保模型能够准确识别车辆品牌和类型特征。

数据增强策略:

训练过程中采用多种数据增强方法提升模型鲁棒性

图53 数据集图像增强方法

Mosaic关闭策略:diyizh在训练的最后 10 个 epoch 关闭 Mosaic 增强(close_mosaic=10),使模型在原始图像分布上精修检测框,提升边界定位精度。这意味着在第1-140轮使用Mosaic数据增强,在第141-150轮使用原始图像进行训练。

数据集质量保证:

为了确保实验数据的可靠性和有效性,本研究的数据集经过严格的质量控制。所有图像均无损坏或无效背景,保证了数据的完整性。标注工作经过多轮人工审核,确保边界框定位精确,类别标注一致且符合定义标准。这些措施有效提升了数据集的质量,为模型训练和性能评估提供了可靠保障。

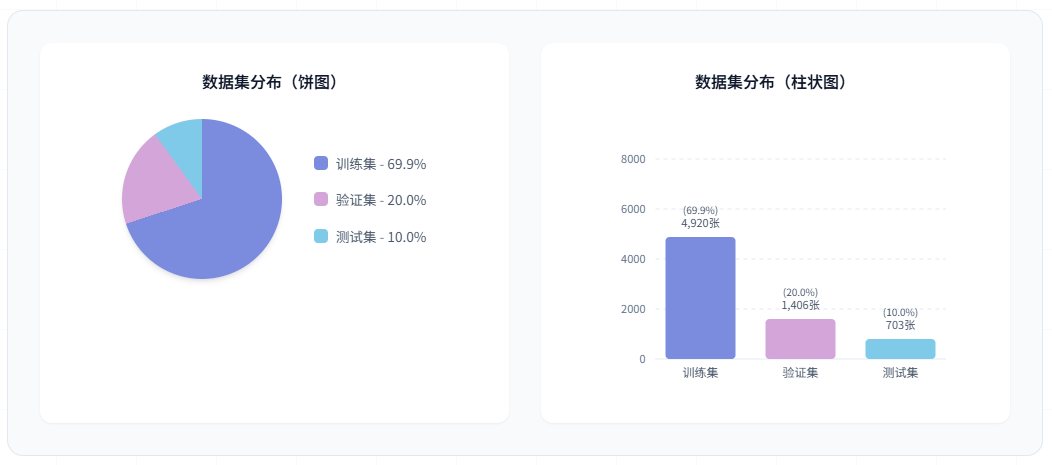

训练流程

模型训练采用端到端的方式,首先加载训练集和验证集进行数据预处理,然后加载YOLOv11预训练权重进行模型初始化,接着使用SGD优化器进行150轮迭代训练,每轮训练后在验证集上评估性能指标,系统自动保存验证集上性能最佳的模型权重,最终输出完整的性能指标和训练曲线。

图54 模型训练流程

训练流程:

1. 开始训练 → 加载训练集和验证集进行数据预处理

2. 模型初始化 → 加载YOLOv11预训练权重(yolo11n.pt),使用标准YOLOv11架构

3. 模型训练 → 使用SGD优化器进行150轮迭代训练,应用数据增强技术

4. 模型验证 → 每轮训练后在验证集上评估性能指标(Precision, Recall, mAP@0.5, mAP@0.5:0.95)

5. 最佳模型保存 → 系统自动监控验证性能,保存验证集上性能最佳的模型权重(best.pt)

6. 训练完成 → 输出完整的性能指标报告和训练曲线图

训练配置

硬件环境:

软件环境

训练超参数

数据增强策略

为提高模型泛化能力,训练过程中采用以下数据增强方法:Mosaic增强将4张图像拼接成一张以增加小目标检测能力;随机翻转以50%的概率对图像进行水平翻转;随机缩放在0.5-1.5倍范围内调整图像尺寸;色彩抖动在HSV色彩空间进行随机调整,其中色调(Hue)调整范围为±0.015、饱和度(Saturation)为±0.7、明度(Value)为±0.4;随机平移在±10%范围内对图像进行位置偏移。

学习率调度策略

学习率调度策略采用线性衰减方式,前3个epoch进行warmup预热,学习率从0线性增长到初始学习率0.01,之后按线性方式从0.01逐步衰减到最终学习率0.0001。

训练结果

性能指标:

经过150轮训练,YOLO11n 基线模型在车辆检测验证集上取得了优异的性能:

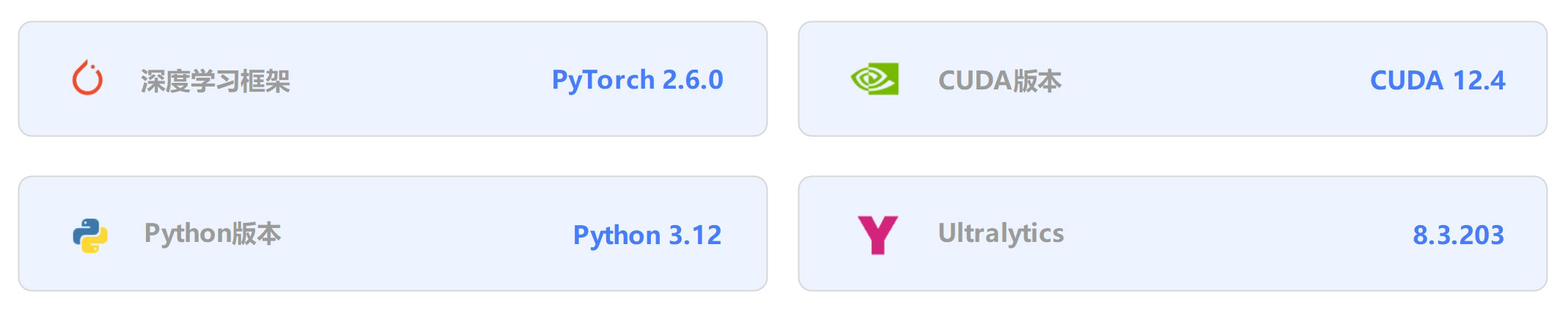

训练曲线分析:

下图展示了模型在150轮训练过程中的完整性能变化,包括损失函数曲线和精度指标曲线:

图55 训练曲线分析

图中展示了10个关键指标的训练过程:训练损失(box/cls/dfl)、验证损失(box/cls/dfl)、精确率、召回率、mAP@50和mAP@50-95

(1)损失函数曲线

训练过程中各项损失函数呈现稳定下降趋势。训练集边界框损失(train/box_loss)从初始的0.62快速下降,经过前3轮学习率预热后加速收敛,在第50轮后趋于稳定,最终收敛至约0.26;训练集分类损失(train/cls_loss)从初始的2.30快速下降,在第30轮后基本稳定在0.20左右,最终收敛至0.16,表明模型分类能力持续提升;训练集DFL损失(train/dfl_loss)从初始的0.98稳步下降至约0.79,分布焦点损失的降低反映了边界框预测精度的提高。验证集损失方面,验证集的box_loss从0.53降至0.27,cls_loss从1.60降至0.15,dfl_loss从0.84降至0.76,均呈现与训练集相似的下降趋势,且曲线平滑无明显波动,表明模型具有良好的泛化能力,未出现过拟合现象。

(2)精度指标曲线

模型性能指标在训练过程中持续提升。Precision(精确率)曲线从初始的56.5%快速上升,在第20轮达到87.1%,在第50轮达到94.7%,随后继续稳步提升,最终稳定在98.2%的高水平;Recall(召回率)曲线从初始的30.7%稳步提升,在第20轮达到86.0%,在第50轮达到94.3%,最终达到97.2%,表明模型对目标的检测能力优异;mAP@50指标从初始的32.8%快速上升,在第20轮达到90.2%,在第50轮达到96.8%,最终稳定在98.7%,显示模型在IoU阈值为0.5时具有极高的检测精度;mAP@50-95指标从初始的26.3%持续上升,在第20轮达到65.9%,在第50轮达到72.4%,在整个150轮训练过程中保持稳定增长态势,最终达到82.3%,表明模型在严格的IoU阈值范围(0.5至0.95)下仍能保持优异的检测性能,证明了模型定位精度的准确性。

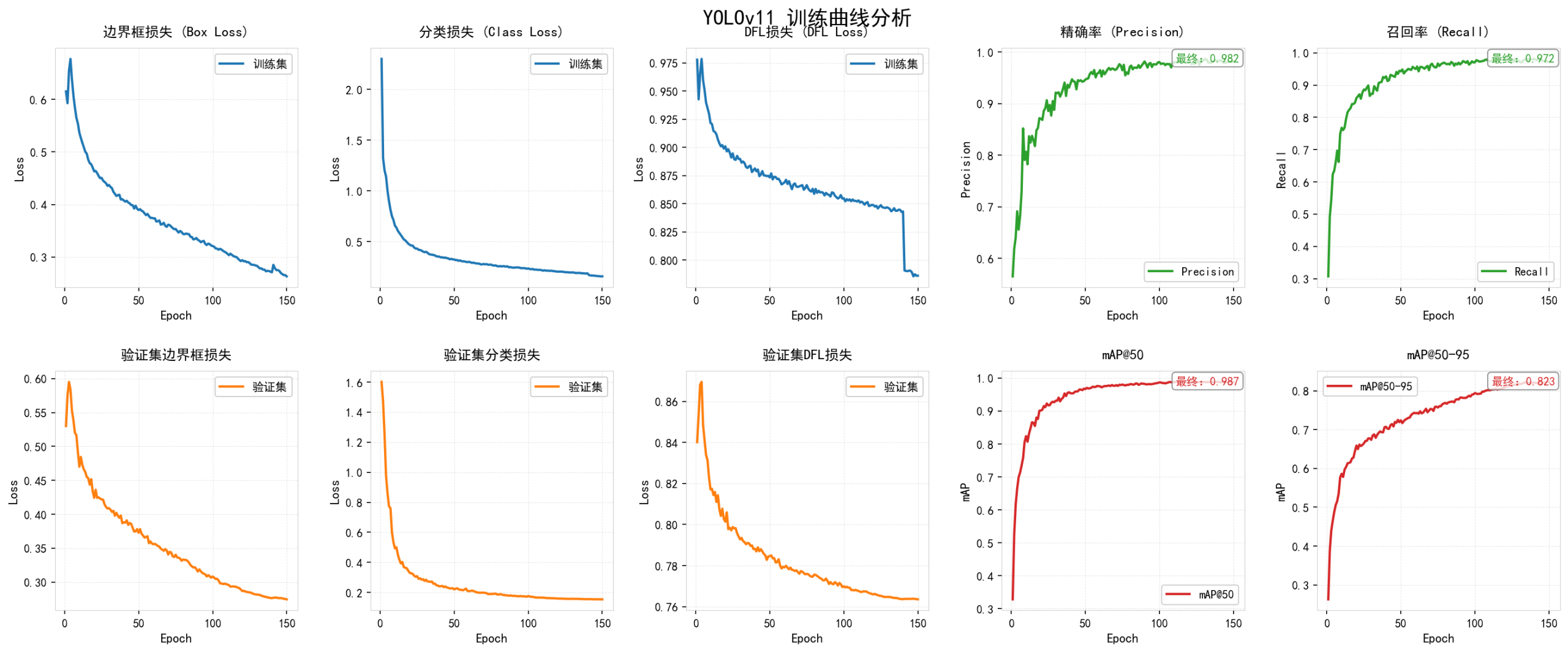

(3)Precision-Recall 曲线

图56 Precision-Recall 曲线

展示模型在不同置信度阈值下的精确率和召回率关系,all classes mAP@0.5达到0.995

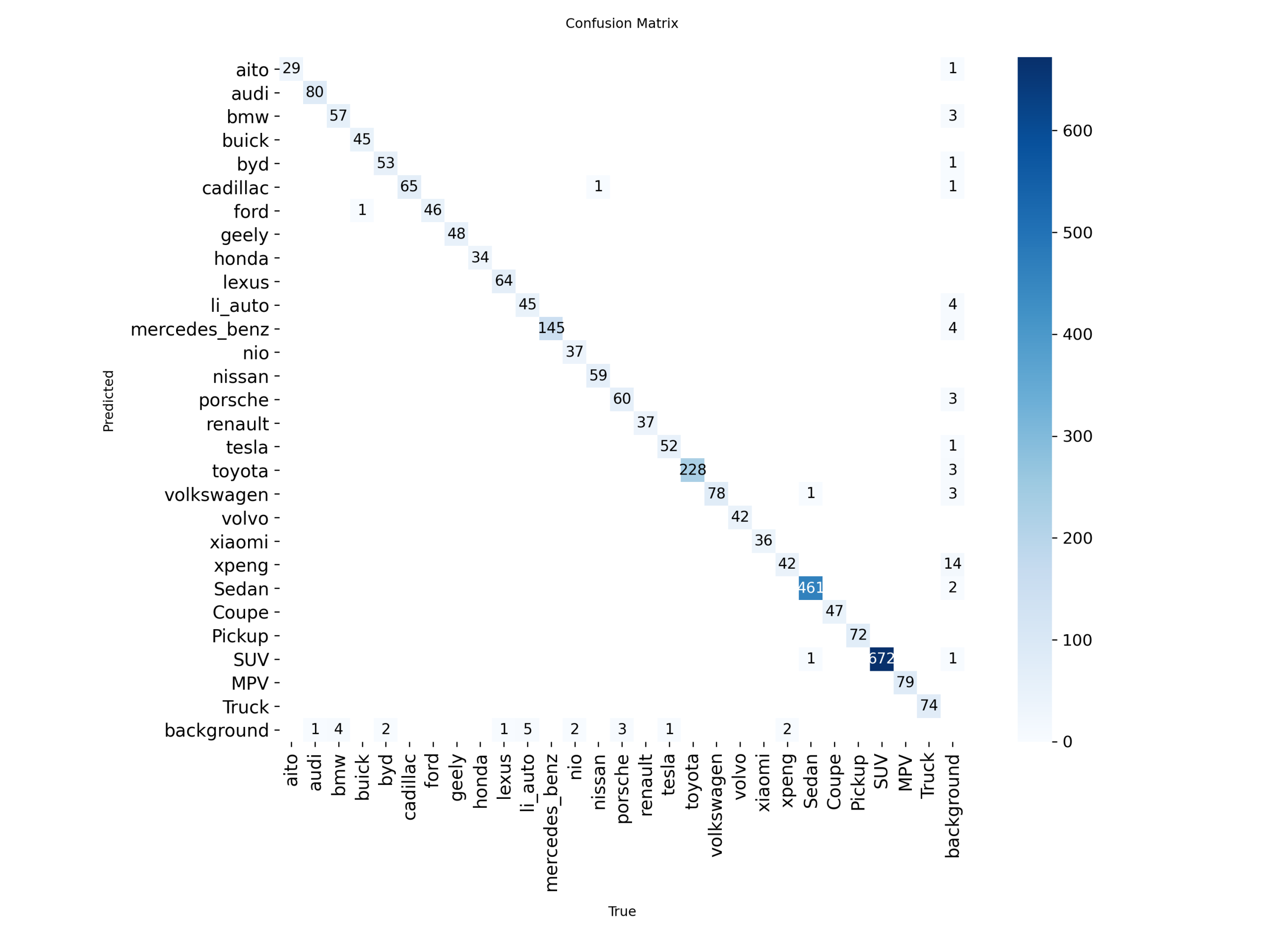

(4)混淆矩阵(归一化)

图57 归一化混淆矩阵

归一化混淆矩阵展示模型的分类准确性

最佳模型选择

训练过程中,系统自动保存验证集上性能最佳的模型,最佳模型出现在第150轮,保存路径为runs/train/yolo11/weights/best.pt,选择标准为验证集mAP@50:0.95指标最高。

训练稳定性分析

- 收敛速度:模型在前20轮快速收敛,第20-100轮稳定提升,第100-150轮精细调优

- 过拟合控制:训练集和验证集损失曲线走势一致,三类损失函数均平稳下降,无明显过拟合现象

- 训练稳定性:损失曲线平滑无剧烈波动,学习率逐步衰减,训练过程稳定可控

- 最终状态:模型在第150轮达到最佳性能,mAP50-95达到82.3%,训练过程稳定收敛

项目资源

我们提供项目的完整技术资源,包括源代码、训练脚本、配置文件、数据集和模型权重等全部内容。代码采用模块化设计,结构清晰,注释完善,支持完全复现论文中的所有实验结果。项目提供详细的文件清单和技术架构说明(网页已经提供),帮助用户快速理解项目结构,便于二次开发和功能扩展。所有资源均已开源,遵循AGPL-3.0协议,用户可自由使用、修改和分发。

关于项目

本项目基于YOLO11n目标检测算法,实现了对车辆类型与品牌的高精度智能检测。模型采用标准的YOLO11n (Nano)架构,在自定义28类车辆数据集上经过150轮训练,在验证集上达到98.7%的mAP@50和82.3%的mAP@50:0.95,同时保持了轻量级特性(模型大小仅5.3MB,参数量2.6M),为智能交通和车辆管理提供了高效的技术支持。

项目背景

随着智能交通系统的快速发展,车辆类型与品牌的精准识别成为交通管理、停车管理、车辆统计等应用场景的核心需求。传统的人工识别方式效率低下、成本高昂,难以满足海量车辆数据的实时处理需求。近年来,深度学习技术在目标检测领域取得突破性进展,为解决这一问题提供了新思路。本项目立足于实际应用需求,针对复杂交通场景下的车辆类型与品牌识别难题,采用基于YOLO11n的轻量级智能检测方案,旨在通过技术手段提升交通管理的智能化水平,降低管理成本,提高车辆识别的准确性和实时性。

作者信息

作者:Bob (张家梁)

项目编号:YOLO_1 & Datasets-2

原创声明:本项目为原创作品

开源协议

本项目采用AGPL-3.0开源协议,允许个人和组织自由使用、修改和分发代码,但基于本项目的衍生作品必须同样开源,且用于提供网络服务时需向用户提供完整源代码。本项目仅供学习研究使用,作者不对使用本项目产生的任何后果承担责任,使用者应遵守当地法律法规,合理合法使用本项目。如本项目对您的研究或工作有所帮助,欢迎引用并注明出处。

评论(0)